C’è un filmato virale in cui il presidente americano Joe Biden scatena una crudele sfuriata contro una persona transgender. «Non sarai mai una vera donna», ringhia il presidente: una scena da accapponare la pelle, che però è completamente falsa. Il video di Biden è infatti stato creato utilizzando l’intelligenza artificiale, mostrando fino a dove si può spingere questa tecnologia. Negli ultimi tempi, di intelligenza artificiale si è parlato soprattutto in riferimento a ChatGPT, il chatbot sviluppato dalla statunitense OpenAI, ma la tecnologia sta rapidamente avanzando anche nella creazione di foto e video.

La popolarità dell’AI però porta con sé varie sfide per le comunità, non ultime quelle che riguardano la politica e la tenuta dei sistemi democratici occidentali, già messi a dura prova negli ultimi anni. Ci saranno probabilmente molti modi interessanti in cui l’intelligenza artificiale verrà impiegata in politica, ma potrebbe anche diventare una minaccia importante per le prossime elezioni, e quelle presidenziali del 2024 negli Stati Uniti saranno il primo vero test.

Abbiamo assistito a cambiamenti piuttosto drammatici nel panorama degli strumenti generativi, soprattutto nell’ultimo anno. La proliferazione di audio, immagini e video di candidati generati dall’AI potrebbe abbattere ulteriormente il confine tra ciò che è reale e ciò che non lo è, sfumando le distinzioni molto più di quanto non sia già avvenuto in un’epoca di disinformazione dilagante.

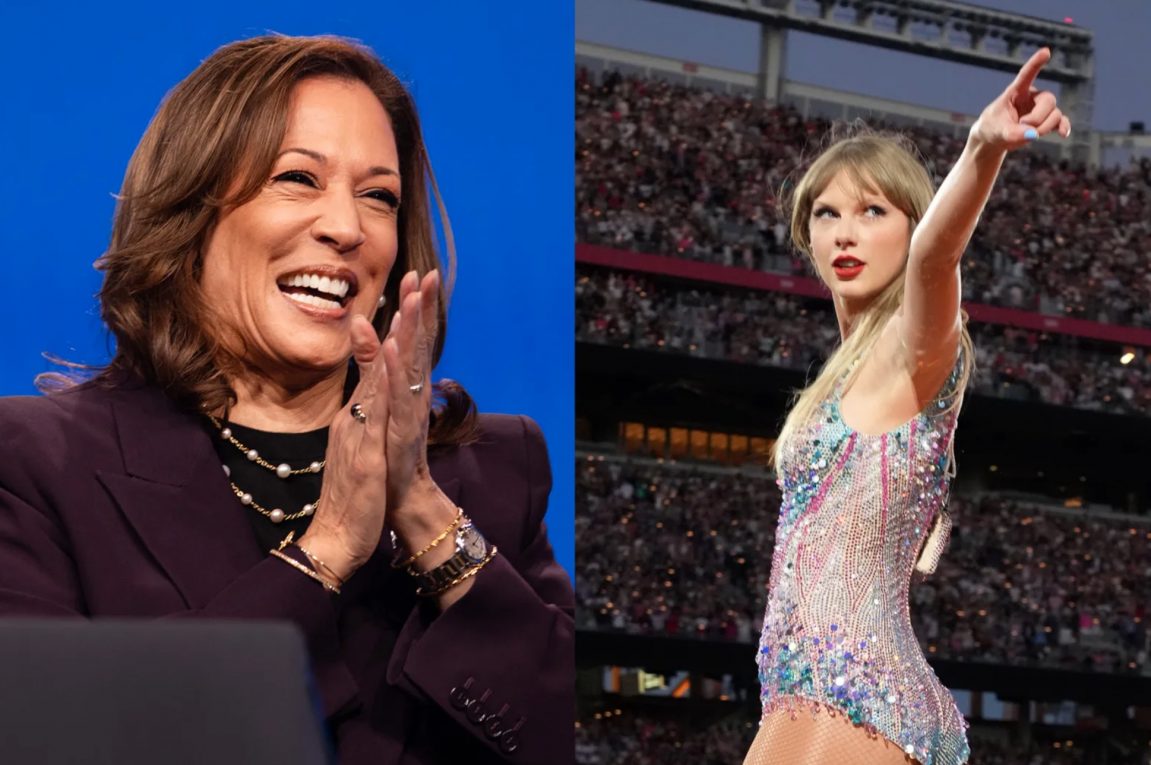

Non si tratta di stabilire se i contenuti generati dall’AI inizieranno a giocare un ruolo in politica, perché sta già accadendo. Immagini e video prodotti dall’intelligenza artificiale con protagonisti Joe Biden e l’ex presidente Donald Trump hanno iniziato a diffondersi su Internet. La domanda è: cosa succederà quando chiunque potrà aprire il proprio laptop e, con uno sforzo minimo, creare rapidamente un video convincente di un politico?

Sotto i riflettori ci sono i deepfake, ovvero foto, video e audio creati grazie all’intelligenza artificiale che, partendo da contenuti reali riescono a modificare o ricreare, in modo realistico, le caratteristiche e i movimenti dell’originale. Fino alla fine dello scorso anno la clonazione di una voce costava migliaia di euro in termini di server e di formazione dell’intelligenza artificiale, ma ora le startup la offrono per pochi dollari. Società come Google e Meta stanno lavorando a software text-to-video, che trasformano un comando in un filmato completo. I deepfake esistono da diversi anni, ma ciò che sta cambiando, e a velocità vertiginosa, è sia la loro efficacia che il numero di persone in grado di crearli.

Restando negli Stati Uniti, anche nella rurale Hillsdale, nel Michigan, l’intelligenza artificiale è in marcia. Jon Smith, presidente repubblicano del quinto distretto congressuale del Michigan, sta organizzando diversi incontri formativi affinché i suoi alleati imparino a usare l’intelligenza artificiale per i social media e la generazione di annunci. Questo, unito a una cultura politica americana sempre più complottista, sta suscitando crescenti preoccupazioni per le prossime elezioni presidenziali; gli esperti dichiarano di aspettarsi che i deepfake saranno utilizzati in modo ampio nel 2024. Trump stesso qualche tempo fa ha postato un video sul suo social Truth, falsificando le dichiarazioni di un conduttore della CNN.

L’inghippo è che con un numero significativo di deepfake postati durante le elezioni, è facile immaginare che qualcuno come Donald Trump possa condividere questo tipo di contenuti sui social media e dichiarare che siano reali. Un deepfake del presidente Biden che dice qualcosa di vergognoso potrebbe uscire poco prima del voto e molte persone potrebbero non scoprire mai che sia stato generato dall’intelligenza artificiale. I dati hanno dimostrato che le fake news si diffondono più di quelle vere: un effetto incandescente della polarizzata politica statunitense.

Anche se i deepfake non dovessero diventare onnipresenti prima delle elezioni del 2024, il solo fatto che questo tipo di contenuti possa essere creato potrebbe influenzare il voto. Sapere che è possibile creare immagini, audio e video fraudolenti con relativa facilità potrebbe indurre le persone a diffidare anche del materiale legittimo in cui si imbattono.

Questo fornisce una scusa perfetta nel caso venisse fuori qualcosa di scomodo per un politico: si può subito liquidare come falso. Sam Gregory, direttore esecutivo del Witness Media Lab, che studia il fenomeno, ha sostenuto che l’esistenza dei deepfake non sarà usata solo per generare contenuti falsi, ma anche per screditare i media autentici.

Cosa si può fare per risolvere questo problema? Sebbene le principali piattaforme come Facebook, Twitter e YouTube si siano impegnate per proibire e rimuovere i deepfake, la loro efficacia nel controllare tali contenuti è variabile.

Una soluzione è rappresentata da una tecnologia chiamata C2PA. Questo sistema firma in modo crittografico qualsiasi contenuto creato da un dispositivo, come un telefono o una videocamera, e documenta chi ha catturato l’immagine, dove e quando. La firma crittografica viene poi conservata in un libro mastro centralizzato. Ciò consentirebbe a chi produce video legittimi di dimostrare che lo sono effettivamente.

Altre opzioni prevedono il cosiddetto fingerprinting e il watermarking di immagini e video. Il fingerprinting consiste nel prelevare i cosiddetti “hash” dai contenuti, che sono essenzialmente stringhe di dati, in modo da poterne verificare la legittimità in un secondo momento. Il watermarking prevede l’inserimento di una filigrana digitale su immagini e video.

Un’ultima possibilità per risolvere il problema sarebbe quella di sviluppare una sorta di fact-checker istantaneo per gli utenti social. Di fronte a qualcosa che potrebbe essere una fake news, lo strumento potrebbe informare rapidamente sulla sua veridicità. Se incappiamo in un’immagine o un video che sembra essere falso, lo strumento potrebbe controllare le fonti per vedere se è stato verificato. Potrebbe essere disponibile all’interno di applicazioni come WhatsApp e Twitter, oppure potrebbe essere un’applicazione a sé stante.

Resta da capire se una di queste possibili soluzioni sarà adottata prima delle elezioni del 2024, ma la minaccia è in crescita e ci sono molti soldi destinati allo sviluppo dell’AI generativa e pochi alla ricerca di modi per prevenire la diffusione di questo tipo di disinformazione.

Il leader del settore OpenAI, che negli ultimi mesi ha cambiato le carte in tavola con il rilascio di ChatGPT e del modello aggiornato GPT-4, è a sua volta alle prese con la questione. A maggio l’amministratore delegato Sam Altman ha dichiarato al Congresso che l’integrità delle elezioni è una “significativa area di preoccupazione” e ha sollecitato una rapida regolamentazione del settore. Dopo la post-verità trumpiana del 2016, una nuova pericolosa tendenza si appresta a riscrivere i concetti di vero e di falso nella politica americana.